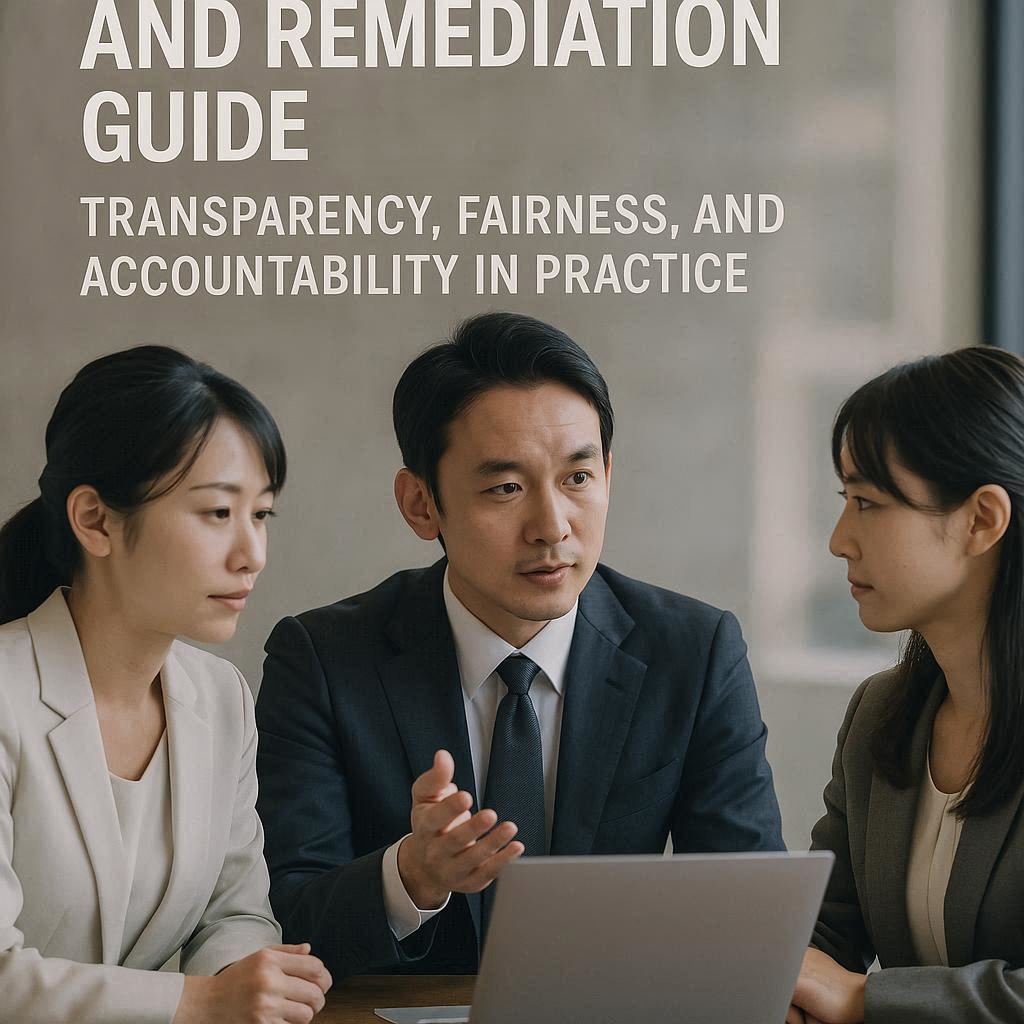

- 1 AIのバイアス検証と是正ガイド:透明性・公平性・説明責任を実務に落とし込む実践

- 2 そのAI判断、本当に「公平」と言えますか?ビジネスリスクを回避し、信頼を築くために

- 3 第1章:なぜ今、AIのバイアス対策が必須なのか?基礎から理解する

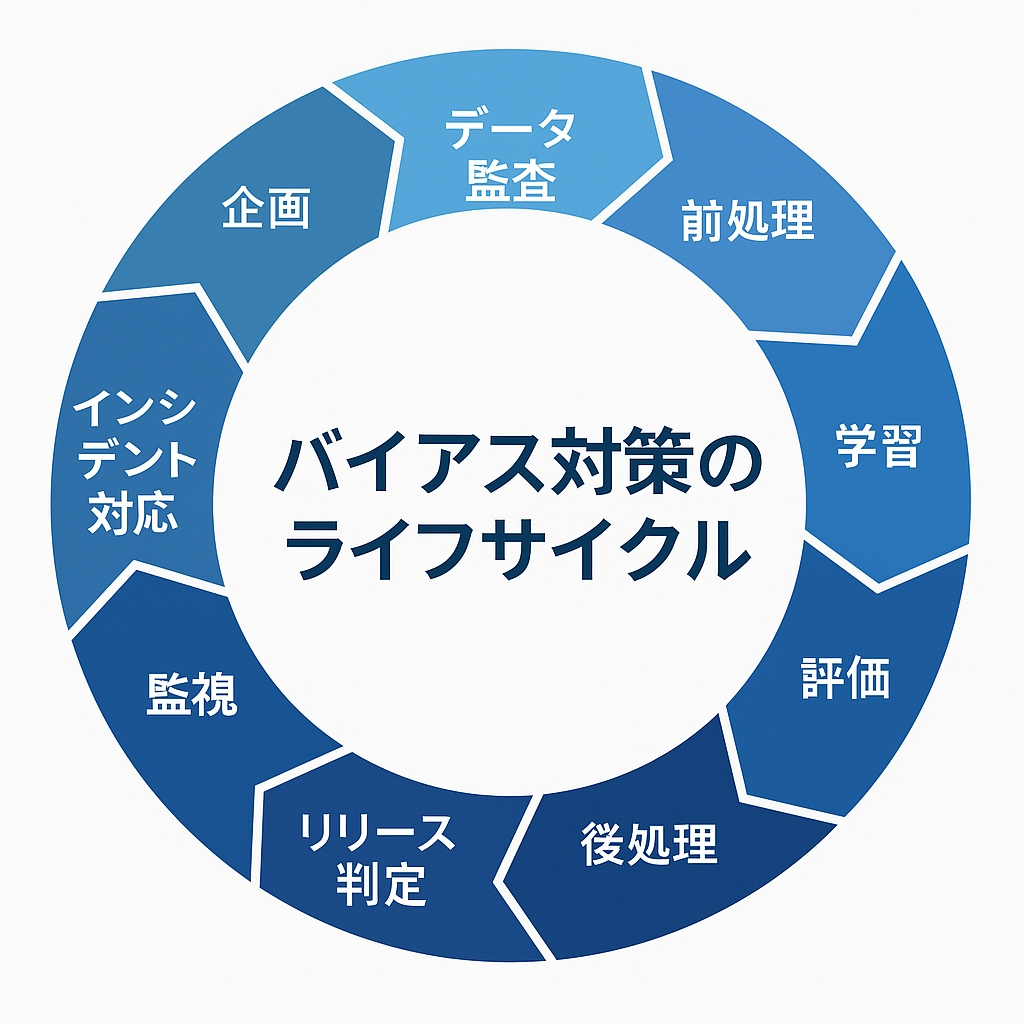

- 4 第2章:【完全版】AIバイアス検証・是正の実践プロセス(ライフサイクル対応)

- 5

- 5.1 Step 1: 企画・リスク定義フェーズ(すべての土台)

- 5.2 Step 2: データ監査フェーズ(表現の公平性を担保する)

- 5.3 Step 3: 前処理フェーズ(データへの介入)

- 5.4 Step 4: 学習・モデル設計フェーズ(アルゴリズムへの介入)

- 5.5 Step 5: 評価・検証フェーズ(誤差の公平性を測定する)

- 5.6 Step 6: 後処理フェーズ(出力への介入)

- 5.7 Step 7: 透明性の確保と説明(ステークホルダーとの対話)

- 5.8 Step 8: リリース判定フェーズ(Go/No-Goの意思決定)

- 5.9 Step 9: 運用・監視フェーズ(継続的な安全網)

- 5.10 Step 10: インシデント対応と説明責任(問題発生時の体制)

- 6 第3章:ユースケース別・判断基準:あなたのプロジェクトではどの公平性を優先すべきか?

- 7 ケーススタディ1:採用・人材評価システム

- 8 第4章:明日から使える!実践ツールキット

- 9 第5章:よくある誤解と落とし穴5選(対策付き)

- 10 まとめと次の一歩

AIのバイアス検証と是正ガイド:透明性・公平性・説明責任を実務に落とし込む実践

そのAI判断、本当に「公平」と言えますか?ビジネスリスクを回避し、信頼を築くために

AIの導入が当たり前になった現代。採用、与信審査、顧客対応など、企業の重要な意思決定プロセスにAIが深く関わるようになりました。しかし、その裏側で「見えないバイアス」が組織の信用と成果を静かに蝕んでいるとしたら、どうしますか?

学習データに潜む社会の歪みや不平等を、AIがそのまま学び、特定の属性を持つ人々に対して意図せず差別や不利益を再生産してしまう。このような事例は、もはや対岸の火事ではありません。さらに、判断プロセスがブラックボックスのまま運用されれば、顧客や社会からの不信を招き、法規制への違反、そして取り返しのつかないブランド毀損につながるリスクをはらんでいます。

この記事は、AIプロジェクトの担当者が「今日から実務に組み込める」バイアス検証と是正の具体的な手順を、体系的に解説する実践ガイドです。データ収集からモデル開発、そして運用監視に至るまで、AIのライフサイクル全体を網羅。すぐに使えるチェックリスト、ユースケース別の判断基準、そして陥りがちな失敗を回避するコツまで、一気通貫で詳しく解説します。

約15分で読み終える頃には、あなたのAIプロジェクトを「リスクが見える化され、対処法がわかり、ステークホルダーに説明できる」状態へと導く、明確なロードマップが手に入っているはずです。

本題に入る前に:この記事のキーポイント

- AIバイアスは社会の鏡: AIバイアスは単なる技術的バグではなく、学習データを通じて社会に存在する不平等がAIに再生産・増幅される現象です。

- 「透明性」は3つの柱で成り立つ: AIガバナンスにおける透明性とは、「説明可能性(なぜこの結論か)」「解釈可能性(どう動くか)」「説明責任(誰が責任を負うか)」の3要素から構成されます。

- 「公平性」は2つの側面から見る: 主に「誤差の公平性(グループ間の予測誤差の差を減らす)」と「表現の公平性(データが社会を適切に代表しているか)」の2つの側面で評価します。

- 対策はライフサイクル全体で: 検証と是正は、企画段階のリスク定義から始まり、データ監査、3つの介入(前処理・学習時・後処理)、人の介在、そして継続的な運用監視まで、一連のプロセスとして組み込む必要があります。

- 事例が示す深刻な影響: 採用AIが特定の性別を不利に扱った事例など、バイアスは現実に深刻な影響を及ぼします。

- 規制強化は待ったなし: 世界的にAIに関するルール整備が進んでおり、透明性と公平性の確保は、倫理的な要請であると同時に、法務・ビジネス上の必須要件になりつつあります。

第1章:なぜ今、AIのバイアス対策が必須なのか?基礎から理解する

具体的な手順に入る前に、なぜAIのバイアス対策がこれほどまでに重要視されているのか、その背景と基本的な概念を整理しましょう。

AIバイアスとは?技術的バグではなく「社会の鏡」

AIバイアスとは、AIモデルの予測や判断が、特定の属性(性別、人種、年齢、出身地など)を持つグループに対して、体系的に有利または不利な結果を生み出す偏りのことを指します。

重要なのは、これが多くの場合、プログラムのコードミスといった「技術的なバグ」ではないという点です。むしろ、AIが学習するデータセットに、私たちの社会が歴史的に抱えてきた偏見や構造的な不平等が反映されていることが根本原因です。AIは、そのデータを忠実に学習することで、意図せずしてその偏りを「再生産」し、時には「増幅」してしまうのです。いわば、AIは社会の歪みを映し出す鏡のような存在と言えます。

見過ごせない3つのリスク:ビジネス、法務、倫理

AIバイアスを放置することは、企業にとって無視できない3つのリスクをもたらします。

- ビジネスリスク: 不公平な判断は、顧客満足度の低下や顧客離れに直結します。ある業界調査では、企業の約75%が「AIの透明性欠如は顧客離れを招く」と認識しています。また、採用AIが優秀な人材を不当に除外したり、与信モデルが優良な顧客を見逃したりすれば、直接的な機会損失につながります。

- 法務・規制リスク: EUのAI法案をはじめ、世界各国でAIに関する規制の導入が進んでいます。これらの規制では、高リスクAIシステムに対して透明性の確保やバイアス評価が義務付けられる傾向にあります。将来、当局からの監査や説明要求に応えられない場合、罰金や事業停止命令といった厳しい措置が課される可能性があります。

- 倫理・ブランドリスク: 差別的なAIの存在が明らかになれば、企業の評判は大きく傷つきます。一度失った社会的な信頼を回復するのは容易ではありません。特にESG(環境・社会・ガバナンス)経営が重視される現代において、AI倫理への取り組みは企業価値を左右する重要な要素です。

具体事例から学ぶバイアスの深刻な影響

過去の事例は、AIバイアスが現実世界に与える影響の大きさを物語っています。

- 採用システム: ある大手テクノロジー企業が開発した採用AIは、過去10年間の応募データ(主に男性からの応募が多かった)を学習した結果、履歴書に含まれる「女性」に関連する単語を減点対象とみなし、女性候補者を不当に低く評価するようになりました。この問題が発覚し、同社はプロジェクトの中止を余儀なくされました。

- 顔認識技術: いくつかの商用顔認識システムが、白人男性に対しては高い精度を示す一方で、有色人種の女性に対しては著しくエラー率が高くなることが研究で示されました。これは、学習データに白人男性の顔画像が偏って多く含まれていたことが一因です。

これらの事例は、AIバイアスが単なる理論上の問題ではなく、人々のキャリア、健康、そして基本的な人権にまで影響を及ぼす喫緊の課題であることを示しています。

AIガバナンスの核心:「透明性」を構成する3つの要素

AIの信頼性を担保する上で中核となるのが「透明性」です。透明性は、以下の3つの要素に分解して考えると理解しやすくなります。

- 説明可能性 (Explainability): 個々の予測や判断に対して、「なぜAIがこの結論に至ったのか」を人間が理解できる形で説明できる能力を指します。例えば、「この住宅ローン申請が承認されたのは、収入の安定性と過去の返済実績が大きく評価されたためです」といった具体的な理由を示すことです。

- 解釈可能性 (Interpretability): モデル全体の挙動やメカニズムを、「どのように機能するのか」を人間が理解できる能力です。例えば、「このモデルは、入力値Xが大きくなるほど、予測値Yも高くなる傾向があります」のように、モデルの内部ロジックを把握できることを指します。

- 説明責任 (Accountability): AIシステムが生み出した結果に対して、誰が、どこまでの責任を負うのかを明確にし、問題が発生した際の対応プロセス(原因究明、是正措置、再発防止策)が整備されている状態を指します。

「公平性」の主要な考え方:何を平等にすべきか?

一口に「公平」と言っても、その定義は文脈によって様々です。AIの文脈では、主に2つの側面から公平性を評価します。

- 表現の公平性 (Representation Fairness): 学習データセットが、AIの適用対象となる現実世界の人口構成を適切に代表しているかを問うものです。特定のグループのデータが極端に少なかったり、質の低いデータしかなかったりする場合、表現の公平性が損なわれていると言えます。データ監査の段階で非常に重要になる観点です。

- 誤差の公平性 (Error Fairness): 異なるグループ間でのモデルの予測誤差(例:偽陽性率、偽陰性率)が、同程度に抑えられているかを問うものです。例えば、病気の診断AIにおいて、あるグループだけ偽陰性(病気を見逃す)率が極端に高い場合、誤差の公平性が著しく損なわれていることになります。

どの公平性を重視すべきかは、AIの用途や、誤った判断がもたらす「害」の種類によって異なります。これについては後ほど詳しく解説します。

第2章:【完全版】AIバイアス検証・是正の実践プロセス(ライフサイクル対応)

AIバイアス対策は、モデルが完成してから行う付け焼き刃の作業ではありません。企画から運用、そして廃棄に至るまで、AIのライフサイクル全体にわたって体系的に組み込む必要があります。ここでは、実務に即した10のステップを具体的に解説します。

Step 1: 企画・リスク定義フェーズ(すべての土台)

すべての始まりは、AIを「何のために、どのように使うか」を明確に定義することです。この最初のステップを曖昧にすると、後工程で必ず手戻りが発生します。

- 目的: AIの利用目的、適用範囲、そして「やらないこと」を文書化し、関係者間で合意形成する。

- やること:

- 用途の明確化: このAIは何を自動化し、何を支援し、最終的な意思決定は誰が下すのかを具体的に記述する。

- 有害な誤差の特定: 偽陽性(False Positive)と偽陰性(False Negative)のどちらがより深刻な害をもたらすかを定義する。例えば、採用選考では「不適格者を見抜けない(偽陽性)」よりも「優秀な候補者を誤って不合格にする(偽陰性)」方が問題かもしれません。一方、重篤な疾患のスクリーニングでは「健康な人を病気と誤診する(偽陽性)」よりも「病気を見逃す(偽陰性)」方が遥かに深刻です。

- 保護対象属性の洗い出し: 公平性を評価する対象となる属性(性別、年齢層など)をリストアップする。法的に保護されている属性や、社会的に配慮が必要な属性を考慮します。

- 人の介入ポイント設計: どこで、誰が、どのような権限でAIの判断をレビューし、覆すことができるのかを定義する。

- 成果物: 用途定義書、リスク評価シート、意思決定フロー図

- 注意点: 「完全自動化」という言葉に安易に飛びつかないこと。影響の大きい意思決定ほど、人の介入を前提とした設計が不可欠です。

Step 2: データ監査フェーズ(表現の公平性を担保する)

モデルの品質はデータの品質で決まります。この段階で、データに潜む偏りを徹底的に洗い出します。

- 目的: 学習データセットの代表性や潜在的なバイアスを可視化し、後の工程での対策の土台を作る。

- やること:

- 分布の確認: 保護対象属性ごとに、サンプル数、欠損値の割合、ラベル(正解データ)の分布などを確認し、グループ間で著しい不均衡がないか分析する。

- 収集プロセスの検証: データがいつ、どこで、どのように収集されたかを確認する。特定の時期や場所に偏りがあると、それがバイアスの源泉になり得ます。

- 測定バイアスの点検: ラベル付けの基準が客観的で一貫しているか、作業者によって判断がブレていないかを確認する。

- プロキシ(代理変数)の検出: 保護対象属性そのものではなくても、それと強く相関する特徴量(例:郵便番号が居住地域や所得層、人種の代理変数になる)を特定し、注意リストに加える。

- 成果物: データ監査レポート、データ品質改善計画

- 注意点: マイノリティグループのサンプル数が不足していることは、後工程での精度低下や公平性指標の不安定化に直結します。必要であれば、追加のデータ収集や、後のステップでの補正(サンプリング手法の工夫など)を計画します。

Step 3: 前処理フェーズ(データへの介入)

データ監査で見つかった問題に対し、モデルを学習させる「前」の段階でデータ自体に修正を加えるアプローチです。

- 目的: 学習データセットの不均衡を是正し、モデルが偏った情報を学習するのを防ぐ。

- やること:

- 再サンプリング:

- オーバーサンプリング: サンプル数が少ないマイノリティグループのデータを複製または人工的に生成して増やす。

- アンダーサンプリング: サンプル数が多いマジョリティグループのデータを間引いて減らす。

- 再重み付け (Reweighting): 各データ点に重みをつけ、マイノリティグループのデータが学習に与える影響が大きくなるように調整する。

- 特徴量の変換・削除: プロキシとして機能する可能性のある特徴量を削除したり、バイアスの影響を受けにくい形に変換したりする。

- 再サンプリング:

- 成果物: データ前処理仕様書、適用したサンプリング/重み付けルール

- 注意点: 過度なデータ操作は、新たなバイアスを生んだり、モデルの全体的な性能を低下させたりする可能性があります。どの手法を選択するかは、元のデータの状態とビジネス目的を照らし合わせ、慎重に判断する必要があります。

Step 4: 学習・モデル設計フェーズ(アルゴリズムへの介入)

モデルの学習プロセス自体に公平性の観点を組み込むアプローチです。

- 目的: モデルが精度を追求するだけでなく、同時に公平性の指標も満たすように学習を制約する。

- やること:

- 公平性制約付き最適化: モデルの学習アルゴリズムの目的関数に、「精度」だけでなく「グループ間の予測率の差を最小化する」といった公平性に関するペナルティ項を追加する。

- 敵対的学習 (Adversarial Debiasing): モデルが予測を行う部分と、その予測から保護対象属性を推測しようとする「敵対的」な部分を同時に学習させる。予測部分が、属性情報を「敵」に推測されないように学習することで、属性への依存度が低い、より公平なモデルを目指す。

- 正則化: モデルが特定の特徴量に過度に依存する(過学習)のを防ぐ技術。これにより、プロキシ変数などの影響を間接的に抑制する効果が期待できます。

- 成果物: モデル学習設定書(使用したアルゴリズム、制約条件など)

- 注意点: このアプローチは高度な技術的知見を要します。また、精度と公平性の間にはトレードオフの関係が生じることが多く、どちらをどの程度優先するか、事前にビジネスサイドと合意しておくことが極めて重要です。

Step 5: 評価・検証フェーズ(誤差の公平性を測定する)

開発したモデルが、ビジネス要件と公平性要件の両方を満たしているかを定量的に評価します。

- 目的: モデルの性能を多角的に評価し、潜在的なバイアスを検出し、リリース可否の判断材料を提供する。

- やること:

- 評価指標の二軸化: AccuracyやAUCといったモデル全体の性能指標だけでなく、必ずグループ別の性能指標と公平性指標を並べて評価する。

- 公平性指標の測定:

- 割合の平等性 (Demographic Parity): 各グループで、ポジティブな結果(採用、ローン承認など)が得られる割合がほぼ等しいか。

- 機会の均等 (Equal Opportunity): 本来ポジティブな結果を得るべき人の中で、正しくポジティブと予測される割合(真陽性率)がグループ間で等しいか。

- 予測値の平等 (Equalized Odds): 真陽性率と偽陽性率の両方がグループ間で等しいか。

- しきい値分析: 多くのAIモデルは0から1の間の確率値を出力し、ある「しきい値」(例:0.5)を超えたらポジティブと判定します。このしきい値を動かすことで、精度と公平性のバランスがどう変化するかを分析し、最適な運用ポイントを探ります。

- 成果物: モデル評価レポート(全体指標、グループ別指標、公平性指標、しきい値分析結果を含む)

- 注意点: 単一の公平性指標だけを見て判断するのは危険です。複数の指標を組み合わせ、ビジネス上のリスクと照らし合わせて総合的に評価することが求められます。

Step 6: 後処理フェーズ(出力への介入)

学習済みのモデルの出力(予測結果)に対して、公平性を高めるための調整を行うアプローチです。

- 目的: 既存のモデルを大きく変更することなく、最終的な意思決定段階でバイアスを是正する。

- やること:

- グループ別しきい値の設定: モデルの出力確率に対して、グループごとに異なる判定しきい値を適用することで、最終的なポジティブ率の差などを調整する。

- 予測結果のキャリブレーション: モデルの予測確率が、実際の確率と一致するように補正する。これにより、異なるグループ間で確率の解釈がズレるのを防ぎます。

- 成果物: 運用ルール定義書(適用するしきい値など)

- 注意点: この手法は実装が比較的容易ですが、なぜグループごとに異なる扱いをするのか、その正当性を外部に説明するのが難しい場合があります。恣意的な操作と受け取られないよう、明確なポリシーとセットで導入する必要があります。

Step 7: 透明性の確保と説明(ステークホルダーとの対話)

技術的な対策だけでなく、AIを利用する人や影響を受ける人に対して、どのように情報を開示し、対話するかが信頼の鍵となります。

- 目的: AIシステムの利用者や社会に対して、その機能、限界、リスクについて誠実に伝え、信頼関係を構築する。

- やること:

- グローバル説明の提供: モデル全体の目的、学習データの概要、主要な判断材料、そして既知の限界やバイアスのリスクについて文書化し、公開する。

- ローカル説明の実装: 個別のケースについて、「なぜこの判断になったのか」を平易な言葉で説明する機能を提供する。(例:「お客様のスコアは、主に取引期間の長さとご利用頻度によって算出されています」)

- 異議申し立てプロセスの整備: AIの判断に納得できない場合に、人間による再審査を要求できる窓口や手順を明確にする。

- 成果物: AIに関する情報開示ドキュメント、FAQ、異議申し立てフロー

- 注意点: 説明は「言い訳」であってはなりません。説明可能性の限界(なぜそう判断したか完全には分からない場合があること)も正直に伝える誠実さが重要です。

Step 8: リリース判定フェーズ(Go/No-Goの意思決定)

開発、ビジネス、法務、倫理など、多様な視点からモデルを最終評価し、本番環境へのリリースを承認する公式なゲートです。

- 目的: 設定した品質基準(性能、公平性、透明性)を満たしていることを確認し、組織として責任ある意思決定を行う。

- やること:

- 判定会議の開催: 関係部署の代表者を集め、評価レポートに基づいて審議する。

- リリース基準の確認: 事前に合意した「最低限満たすべき公平性基準」や「許容できないリスク」に抵触していないかを確認する。

- 意思決定と記録: 判定結果(承認、条件付き承認、差し戻し)とその理由を議事録として明確に記録する。

- 成果物: リリース判定会議議事録、承認記録

- 注意点: ビジネス上の要請が強くても、公平性の基準をクリアできない場合は、勇気を持ってリリースを延期または中止する判断が必要です。このガバナンスプロセスが形骸化しないようにすることが重要です。

Step 9: 運用・監視フェーズ(継続的な安全網)

AIモデルはリリースして終わりではありません。社会の変化やデータの変化に伴って、新たなバイアスが発生する可能性があるため、継続的な監視が不可欠です。

- 目的: 運用中のAIモデルの性能と公平性が、時間の経過とともに劣化していないかを定常的に監視し、問題の早期発見と対応を行う。

- やること:

- メトリクスの定常監視: モデルの全体精度やグループ別の公平性指標をダッシュボードなどで可視化し、定期的にレビューする。

- データドリフトの検知: 運用環境で入力されるデータの分布が、学習時と大きく異なっていないかを監視する。分布の変化は、モデルの性能劣化やバイアス発生の兆候です。

- アラートシステムの実装: 監視している指標が、事前に設定したしきい値から逸脱した場合に、担当者に自動で通知する仕組みを構築する。

- フィードバックループの確立: ユーザーからの苦情や現場担当者の気づきを収集し、モデルの再学習や改善に活かす仕組みを作る。

- 成果物: 監視ダッシュボード、アラート設定、定期監査レポート

- 注意点: 短期間のテストで問題がなかったからといって安心は禁物です。市場環境やユーザー層の変化は、静かにバイアスを再発させます。「一度監査すれば終わり」という考えは捨てましょう。

Step 10: インシデント対応と説明責任(問題発生時の体制)

万が一、深刻なバイアスや意図しない差別事象が発生した場合に、迅速かつ適切に対応するための計画を事前に準備しておきます。

- 目的: インシデント発生時の混乱を最小限に抑え、被害の拡大を防ぎ、ステークホルダーへの説明責任を果たす。

- やること:

- インシデントの定義: 何が起きたら「インシデント」と見なすか(例:公平性指標が3期連続でしきい値を超えた、重大な苦情が複数発生した)を定義する。

- 対応プロセスの策定: 報告ルート、初動対応(影響範囲の特定、暫定停止の判断)、原因究明、再発防止策の立案といった一連の流れを文書化しておく。

- コミュニケーションプランの準備: 影響を受ける顧客や社会に対して、いつ、誰が、何を、どのように伝えるかの計画を立てておく。誠実で迅速なコミュニケーションが信頼回復の鍵です。

- 成果物: インシデント対応計画書、コミュニケーションプラン

- 注意点: 問題を隠蔽しようとすることは、最悪の対応です。たとえ組織に非があったとしても、それを認め、真摯に再発防止に取り組む姿勢を示すことが、長期的な信頼につながります。

第3章:ユースケース別・判断基準:あなたのプロジェクトではどの公平性を優先すべきか?

すべてのユースケースで万能な公平性指標は存在しません。AIの目的と、誤った判断がもたらす害の種類によって、優先すべき公平性の考え方は異なります。

ケーススタディ1:採用・人材評価システム

- 重視すべき公平性: 機会の均等 (Equal Opportunity)。本来採用されるべき優秀な候補者が、属性を理由に見逃されていないか(偽陰性率がグループ間で平等か)が極めて重要。

- 主なリスク: 過去の応募データに存在する偏り(例:特定の職種で男性応募者が多い)をAIが学習し、将来の候補者選考でバイアスを再生産してしまう。

- 対策のポイント: データの再重み付けや再サンプリングを検討。AIによるスクリーニングはあくまで参考情報とし、面接や最終判断は必ず多様な背景を持つ人間が関与するプロセスを設計する。

ケーススタディ2:与信審査・金融サービス

- 重視すべき公平性: 割合の平等性 (Demographic Parity) や予測値の平等 (Equalized Odds)。ローン承認率などが特定のグループで極端に低くならないように配慮しつつ、返済能力のある人を正しく承認し、ない人を正しく否決する精度もグループ間で平等であることが求められる。

- 主なリスク: 郵便番号や学歴などが、本来考慮すべきでない属性の代理変数となり、意図しない差別(赤線引きなど)につながる。

- 対策のポイント: 代理変数の影響を慎重に分析し、必要に応じて特徴量から除外する。判断理由の説明可能性を確保し、顧客からの問い合わせや異議申し立てに丁寧に対応できる体制を構築する。

ケーススタディ3:顧客ターゲティング・レコメンド

- 重視すべき公平性: 主に表現の公平性。特定のグループに不快感や疎外感を与えるような偏ったレコメンドを避ける。

- 主なリスク: 透明性の欠如が顧客の不信感を招き、サービス離脱につながる。「なぜこの広告が表示されるのか」が不透明だと、監視されているような不快感を与える。

- 対策のポイント: パーソナライゼーションのロジックについて、ある程度の透明性を確保する(例:「この商品を見た人にはこちらもおすすめです」)。ユーザーが自身のデータをコントロールし、レコメンドをオプトアウトできる選択肢を提供することが信頼につながる。

第4章:明日から使える!実践ツールキット

理論を理解したところで、次に行動に移すための具体的なツールが必要です。

実装チェックリスト

あなたのプロジェクトで、以下の項目が満たされているか確認してみましょう。

□ 企画・ガバナンス

- [ ] AIの利用目的と「やらないこと」が文書化されているか

- [ ] 最も避けるべき有害な誤差(偽陽性/偽陰性)について合意があるか

- [ ] 人による最終判断のポイントと権限が明確に設計されているか

- [ ] 関係部署(法務、倫理、事業部)が参加するリリース判定プロセスがあるか

- [ ] インシデント発生時の対応計画が準備されているか

□ データ

- [ ] 保護対象属性ごとのデータ分布(サンプル数、品質)が監査されているか

- [ ] 代理変数となりうる特徴量が洗い出され、対応方針が決められているか

- [ ] データの収集方法やラベリング基準に潜在的なバイアスがないかレビューされているか

□ モデル開発・評価

- [ ] 全体精度だけでなく、グループ別の性能指標と公平性指標を測定しているか

- [ ] 精度と公平性のトレードオフを考慮し、運用しきい値を決定した根拠が記録されているか

- [ ] バイアス是正手法(前処理、学習時、後処理)の適用を検討し、その選択理由が文書化されているか

□ 運用・透明性

- [ ] 運用中のモデル性能と公平性を監視するダッシュボードやアラートがあるか

- [ ] AIの判断理由を説明するための仕組み(グローバル/ローカル)が用意されているか

- [ ] ユーザーが判断に異議を申し立て、人間による再審査を要求できるプロセスがあるか

ハンズオン:最初のバイアス検証ミニフロー

どこから手をつけていいか分からない、という場合は、まずこの小さなサイクルを回してみることをお勧めします。

- 監査レポート作成: まずは既存のデータセットについて、保護対象属性(例:年代)を一つ選び、グループごとのサンプル数と結果ラベルの分布を可視化するレポートを作成します。

- ベースライン測定: 既存モデル(もしあれば)を使い、グループごとの正解率、偽陽性率、偽陰性率を計算し、グループ間でどの程度の差があるかを測定します。

- 改善案の立案: 測定結果に基づき、「マイノリティグループのデータをオーバーサンプリングする」「判定しきい値をグループごとに調整する」といった改善案を2〜3つ考えます。

- 影響評価と選定: 各改善案が、公平性指標とビジネスKPI(全体精度など)にどのような影響を与えるかをシミュレーションし、最もバランスの取れた案を一つ選びます。

- レビューと記録: なぜその案を選んだのか、その結果どのようなトレードオフを受け入れたのかをチームでレビューし、決定事項として記録します。

この小さなフローを経験するだけでも、バイアス検証・是正の具体的な勘所が掴めるはずです。

第5章:よくある誤解と落とし穴5選(対策付き)

最後に、AIバイアス対策を進める上で陥りがちな誤解とその回避策を紹介します。

- 誤解1:精度が高ければ公平なはずだ

- 真実: 全体精度が99%でも、特定のマイノリティグループでのみエラーが集中している可能性があります。必ずグループ別の指標を確認してください。

- 誤解2:性別や人種などの属性データを使わなければ差別は起きない

- 真実: 郵便番号、学歴、過去の購買履歴などが、意図せず属性の代理変数(プロキシ)として機能します。プロキシの検出と影響分析が不可欠です。

- 誤解3:とにかくデータをたくさん集めればバイアスは解決する

- 真実: 偏ったプロセスで収集された質の悪い大量データは、バイアスを強化するだけです。量よりも質、特にデータの代表性が重要です。

- 誤解4:一度監査して対策すれば、もう安心だ

- 真実: 社会や市場は常に変化しています。運用を開始してから入力されるデータの傾向が変わり、新たなバイアスが発生することは日常茶飯事です。継続的な監視と定期的な再評価の仕組みがなければ、対策は形骸化します。

- 誤解5:AIの判断理由を説明できれば、どんな結果でも許される

- 真実: 説明は、信頼のための必要条件ですが、十分条件ではありません。たとえ理由が説明できても、その結果が著しく不公平であるならば、モデル自体の修正や運用停止を検討するべきです。説明責任には、是正する責任も含まれます。

まとめと次の一歩

本記事では、AIモデルに潜むバイアスのリスクから、その検証と是正を行うための具体的な実践プロセスまでを網羅的に解説しました。

本記事の重要ポイントサマリー

- AIバイアスは、技術的な問題であると同時に、社会的な偏りを反映する組織のガバナンスの問題です。

- 信頼されるAIの実現には、「透明性(説明可能性・解釈可能性・説明責任)」と「公平性(表現の公平性・誤差の公平性)」の両輪が不可欠です。

- バイアス対策は、企画から運用監視まで、ライフサイクル全体にわたる継続的なプロセスとして設計する必要があります。

- どの公平性を優先すべきかはユースケースによって異なります。判断がもたらす「害」の種類を特定し、関係者間で合意することが重要です。

- 「AIだから中立・公平」は幻想です。公平に近づけるのは、人間の責任ある介入と、継続的な検証・是正の仕組みに他なりません。

あなたのチームが明日から始めるべきこと

この記事を読んだあなたが次に取り組むべきアクションは明確です。

- 現状把握: まず、現在開発・運用しているAIプロジェクトについて、本記事の「実装チェックリスト」を使って自己評価を行ってみてください。どこにギャップがあるかを可視化することが第一歩です。

- 小さな成功体験: 次に、「ハンズオン:最初のバイアス検証ミニフロー」を参考に、一つのモデル、一つの属性に絞って、バイアスの測定と改善シミュレーションを実施してみましょう。

- 体制づくり: この問題を個人の努力に終わらせず、組織的な取り組みにするために、関連部署(開発、ビジネス、法務など)を巻き込んだ定期的なレビュー会議を設置することを提案してください。

AIバイアスへの取り組みは、もはや一部の専門家だけの課題ではありません。信頼されるテクノロジーを社会に提供し、持続的なビジネス成長を実現するために、すべてのAIプロジェクト関係者が取り組むべき必須の責務です。今日から、その第一歩を踏み出しましょう。

「AIは公平」という幻想との闘い方:データと現実の狭間の人と組織の壁 「AIのバイアス検証と是正ガイド」の記事、お読みいただけましたでしょうか。あの記事では、AIの公平性や透明性を確保するための技術的なライフサイクルやフレームワーク[…]