- 1 シャドーAI対策ガイド|禁止せずにリスクを管理し活用する実践ロードマップ

- 2 第1章:基礎理解 – なぜシャドーAIは生まれ、急速に広がるのか?

- 3 第2章:数字で見るシャドーAIの現状と潜在的リスク

- 4 第3章:禁止は悪手!シャドーAI対策の成功を導く3つの基本原則

- 5 第4章:【ステップ1:予防】リスクを未然に防ぐための基盤づくり

- 6 第5章:【ステップ2:検知】隠れた利用を可視化する技術と運用

- 7 第6章:【ステップ3:対応】インシデント発生時の具体的なアクションプラン

- 8 第7章:【部門別】現場で使えるシャドーAIガードレール具体例

- 9 第8章:安全な公式AIツール選定で失敗しないための7つの基準

- 10 第9章:シャドーAI対策で陥りがちな5つの落とし穴と回避策

- 11 第10章:シャドーAI対策に関するよくある質問(FAQ)

- 12 まとめ:シャドーAIを統制されたイノベーションに変えるために

シャドーAI対策ガイド|禁止せずにリスクを管理し活用する実践ロードマップ

生成AIの登場は、多くのビジネス現場で業務効率を劇的に向上させる可能性を秘めています。しかしその裏側で、企業のIT部門が承認していないAIツールが従業員によって利用される「シャドーAI」が、静かに、しかし確実に広まっています。

「少しでも早く資料を仕上げたい」「英語のメールを自然な日本語にしたい」。そんな現場の切実なニーズから生まれるシャドーAIは、善意から始まることがほとんどです。しかし、その手軽さと引き換えに、機密情報の漏洩、セキュリティ侵害、法務・コンプライアンス違反といった、企業の根幹を揺るがしかねない重大なリスクを内包しています。

多くの企業が「AI利用は原則禁止」という方針を打ち出しますが、それだけでは問題の根本解決にはなりません。むしろ、利用がさらに見えにくい形(アンダーグラウンド化)で進み、リスクを増大させることさえあります。

この記事は、シャドーAI問題に直面するIT部門、セキュリティ担当者、DX推進担当者のために書かれました。単なるリスクの解説に留まらず、実務で明日から使える「予防・検知・対応」の具体的な運用手順と、シャドーAIを組織のイノベーション源へと昇華させるための「可視化・分析・公式化」という現実的なロードマップを、豊富なチェックリストと具体例を交えて徹底的に解説します。

この記事を読み終える頃には、あなたは自社の状況に合わせたシャドーAI対策の全体像を理解し、具体的な計画を立て始めることができるようになっているはずです。

この記事のキーポイント(約90秒で把握)

- シャドーAIとは?: 組織の公式な承認や管理下にない状態で、従業員が業務にAIツールを利用すること。生産性向上が主な動機ですが、機密情報の入力やアクセス制御の欠如が深刻なリスクを生み出します。

- なぜ問題なのか?: ある調査では、業務における生成AI利用の多くが企業外アカウント経由で行われていると指摘されています。これは、IT部門が利用実態を把握できていないことを意味します。別の調査では約7割の企業が未承認AIの利用を検知しており、氷山の一角である可能性が高いのが現状です。

- 主なリスク: データ漏洩(機密情報、個人情報)、セキュリティ侵害(マルウェア感染、脆弱性)、コンプライアンス違反(著作権、個人情報保護法)、業務上の損害(誤情報による意思決定ミス、ブランド毀損)など、多岐にわたります。

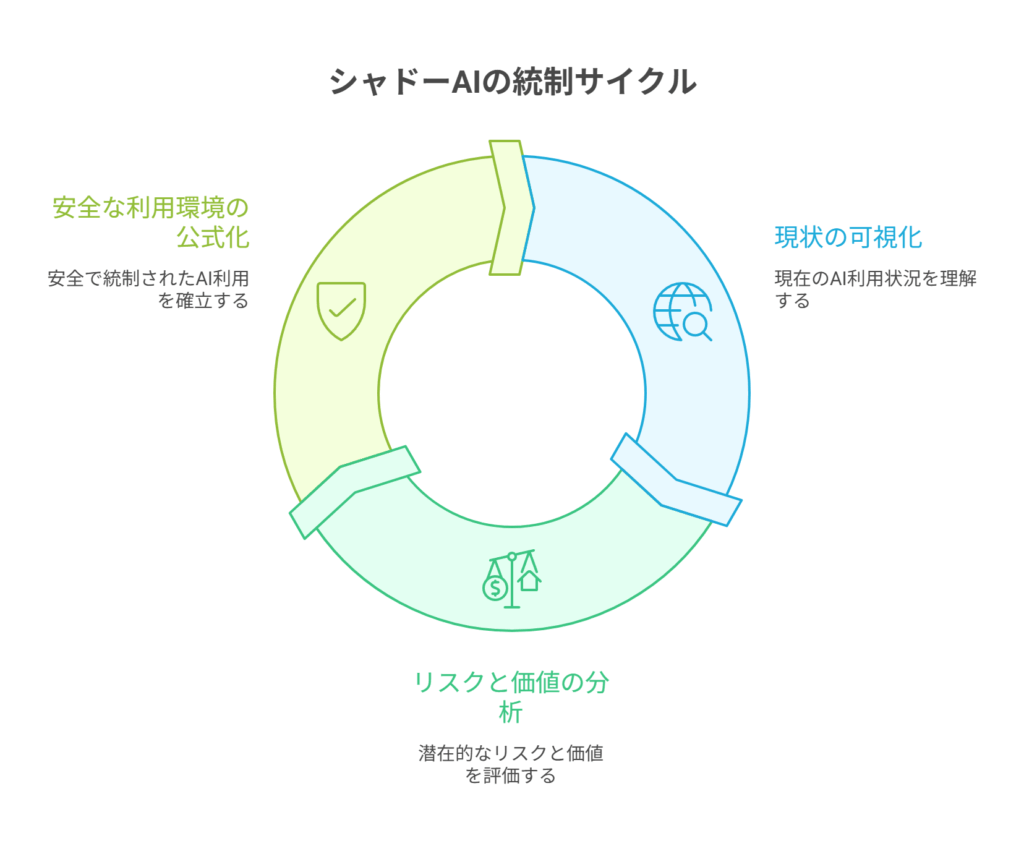

- 成功への基本方針: 「一律禁止」ではなく、「可視化 → 分析 → 公式化」のサイクルを回すこと。現場の生産性向上ニーズを汲み取り、安全な形で公式ツールを提供することで、リスクを最小化しつつAI活用の価値を最大化します。

- 具体的な実践ステップ: 本記事では、ポリシー策定と教育による「予防」、ログ監視と分析による「検知」、インシデント発生時の「対応」フロー、そして安全な「公式ツール」の導入と継続的改善まで、網羅的に解説します。

第1章:基礎理解 – なぜシャドーAIは生まれ、急速に広がるのか?

シャドーAI問題を正しく理解するためには、まずその定義と発生の背景を知る必要があります。なぜ従業員は、リスクがあると知りながらも未承認のツールを使ってしまうのでしょうか。

シャドーAIの定義

シャドーAIとは、組織のIT部門による公式な承認や管理・監督の外で、従業員が自己判断で業務目的で利用するAIツールやサービス全般を指します。これは、以前から問題視されてきた「シャドーIT」(未承認のクラウドストレージやチャットツールの利用)のAI版と考えることができます。

具体的には、以下のようなケースが該当します。

- 個人アカウントで登録した無料の生成AIサービスに、業務用の文章やデータを入力して要約・翻訳させる。

- Webブラウザの拡張機能として提供されるAIライティング支援ツールを、顧客へのメール作成に利用する。

- プログラマーが、ソースコードの断片を外部のAIコード生成サービスに貼り付けてデバッグやリファクタリングを行う。

これらの行為は、多くの場合、従業員の「もっと効率的に仕事を進めたい」という前向きな動機から発生します。しかし、その手軽さの裏には、組織的な管理が及ばないことによる深刻なリスクが潜んでいます。

シャドーAIが生まれる背景:現場のニーズとIT部門のジレンマ

シャドーAIが蔓延する根本的な原因は、現場の求めるスピード感や利便性と、企業が求めるセキュリティやガバナンスの間に存在するギャップです。

- 圧倒的な利便性と即効性: 生成AIツールは、ブラウザ上で数クリックするだけで利用を開始できます。資料の要約、メールの文面作成、アイデアの壁打ち、コードの生成といった日常業務が、これまでとは比較にならない速さで完了します。この「すぐに使える」「すぐに結果が出る」という体験は、一度味わうと手放しがたいものです。

- 公式ツールの提供遅れ: 一方で、企業が公式にAIツールを導入するには、セキュリティ評価、リスク分析、予算確保、利用ポリシーの策定、従業員へのトレーニングなど、多くのステップを踏む必要があり、時間がかかります。このタイムラグが、現場の従業員に「待っていられない」と感じさせ、シャドーAIの利用を後押しします。

- 管理の難しさ: シャドーAIの多くは、個人のメールアドレスで登録できるWebサービスやブラウザ拡張機能として提供されます。そのため、従来のIT資産管理ツールでは利用実態を把握しにくく、水面下で利用が拡大しやすいという特徴があります。

つまり、シャドーAIは単なる従業員のルール違反ではなく、組織のDX推進における構造的な課題が表面化した現象と捉えるべきなのです。

第2章:数字で見るシャドーAIの現状と潜在的リスク

シャドーAIは、もはや一部の先進的な従業員だけの問題ではありません。国内外の調査から、その利用がすでに多くの企業で常態化しつつあることが明らかになっています。

業務利用の実態を示すデータ

- 企業外アカウントの蔓延: ある調査では、業務で生成AIを利用している従業員の多くが、企業から提供されたアカウントではなく、個人で作成した企業外アカウントを使用していることが示唆されています。これは、IT部門やセキュリティチームが利用状況を全く把握・管理できていないことを意味し、データがどこでどのように扱われているかが完全にブラックボックス化している危険な状態です。

- 検知される未承認利用: 別の大手調査会社の報告によると、約69%の企業が、自社ネットワーク内で従業員による未承認のAIアプリ利用を検知したと回答しています。これはあくまで「検知できた」数字であり、検知をすり抜けて利用されているケースを含めると、実際にはさらに多くの企業でシャドーAIが蔓延していると推測されます。

リスクの具体像:あなたの会社で起こりうる5つのシナリオ

では、シャドーAIの利用は具体的にどのようなリスクを引き起こすのでしょうか。ここでは、特に重大な5つのリスクシナリオを深掘りします。

1. データ漏洩・プライバシー侵害

最も深刻かつ発生しやすいリスクです。従業員が良かれと思って入力した情報が、意図せず外部に漏洩する可能性があります。

- 入力データが学習に使われる: 無料のAIサービスの多くは、利用規約で「入力されたデータをサービス改善(AIモデルの再学習)のために利用する」と定めています。ここに顧客情報、未公開の財務データ、開発中の製品仕様、個人情報などを入力してしまうと、それらがAIモデルに取り込まれ、他のユーザーへの回答として出力されてしまう可能性があります。

- アクセス制御の不備: 個人アカウントで利用しているAIサービスの認証情報(パスワードなど)が漏洩した場合、第三者がそのアカウントにログインし、過去のやり取り(プロンプトと出力の履歴)をすべて閲覧できてしまいます。そこにもし機密情報が含まれていれば、直接的な情報漏洩に繋がります。

2. セキュリティ侵害の新たな入口

シャドーAIは、サイバー攻撃者にとって新たな侵入経路となり得ます。

- 悪意のあるツール・拡張機能: AIを騙る便利なツールやブラウザ拡張機能の中には、マルウェアやスパイウェアが仕込まれているものがあります。従業員が安易にインストールしてしまうと、端末内の情報を盗まれたり、ランサムウェアに感染させられたりする可能性があります。

- 設定ミスによる情報公開: 開発チームがAI開発のために利用するクラウドストレージやプラットフォームでアクセス権限の設定を誤り、本来非公開であるべき学習データやソースコードが、インターネット上から誰でもアクセスできる状態になってしまうインシデントも発生しています。

3. 法令・契約・倫理違反

AIの利用は、知らず知らずのうちに法的な問題を引き起こす可能性があります。

- 著作権侵害: AIが生成した文章や画像が、既存の著作物を無断で複製・改変したものである可能性があります。これを自社のコンテンツとして公開した場合、著作権侵害で訴えられるリスクがあります。

- 個人情報保護法違反: 顧客の個人情報を含むデータをAIサービスに入力する行為は、本人の同意なく第三者に個人データを提供したとみなされ、個人情報保護法に抵触する可能性があります。

- 顧客向けAIの誤情報: 実際に海外の航空会社で、公式ウェブサイトのチャットボットが誤った運賃情報を顧客に案内し、後に裁判所がその案内に基づく割引運賃での搭乗を命じた事例が報じられました。AIによる誤った回答が、企業の法的責任に発展しうることを示す教訓です。

4. データ品質の劣化と誤った意思決定

AIは入力されるデータに大きく依存します。そのデータの品質管理ができていないと、ビジネスに深刻な悪影響を及ぼします。

- データ汚染(Data Poisoning): 悪意のある第三者が、AIの学習データに意図的に誤った情報や偏った情報を注入(汚染)することで、AIの出力結果を不正に操作する攻撃手法です。例えば、株価予測AIに偽のニュースを学習させ、誤った予測を出させて市場を混乱させる、といった事態が考えられます。

- ハルシネーション(幻覚)の鵜呑み: 生成AIは、事実に基づかないもっともらしい嘘の情報を生成すること(ハルシネーション)があります。従業員がAIの回答をファクトチェックせずに鵜呑みにし、それを基に重要な経営判断や顧客への提案を行ってしまった場合、大きなビジネス上の損失や信用の失墜に繋がります。

5. ガバナンスの崩壊

シャドーAIの黙認は、組織全体の規律を緩ませ、より大きな問題へと発展する可能性があります。

- “抜け道文化”の常態化: 「ルールを守らなくても、便利なツールを使えば仕事が速く進む」という成功体験が積み重なると、従業員のコンプライアンス意識が低下し、他の領域でもルール違反が起こりやすくなります。

- 統制不能なコスト: 各部署や従業員が個別に有料のAIサービスを契約し始めると、IT部門が把握できないところでコストが膨れ上がり、IT予算の適正な管理が困難になります。

第3章:禁止は悪手!シャドーAI対策の成功を導く3つの基本原則

シャドーAIのリスクを前にして、多くの企業が取りがちな最初の対応は「一律禁止」です。しかし、このアプローチはほとんどの場合、失敗に終わります。現場の生産性向上への強いニーズを無視するため、反発を招き、利用がさらにアンダーグラウンド化するだけだからです。

成功するシャドーAI対策は、トップダウンの「禁止」ではなく、現場を巻き込んだボトムアップの「活用推進」を目指します。そのための中心的な考え方が、「可視化」「分析」「公式化」という3つの原則です。

原則1:可視化 (Visualization) – まずは現状を正確に知る

対策の第一歩は、敵(シャドーAI)の正体を知ることです。現在、社内で「誰が」「どのAIツールを」「どのような業務に」「どれくらいの頻度で」利用しているのかを、可能な限り正確に把握します。

- 技術的なアプローチ:

- ネットワークログ分析: プロキシやファイアウォールのログを分析し、社内から生成AIサービスへのアクセス状況を洗い出します。

- CASB/SASEの活用: CASB (Cloud Access Security Broker) やSASE (Secure Access Service Edge) といったソリューションを導入し、利用されているSaaSアプリケーションを自動的に検知・分類します。

- エンドポイント監視 (EDR): EDR (Endpoint Detection and Response) ツールを用いて、各端末で実行されているアプリケーションやブラウザ拡張機能を監視します。

- 組織的なアプローチ:

- 匿名アンケート: 従業員が安心して回答できるよう、匿名形式でAIツールの利用実態に関するアンケートを実施します。罰則がないことを明確に伝え、正直な回答を引き出すことが重要です。

- ヒアリングと申告制度: 各部門のキーパーソンにヒアリングを行ったり、利用したいAIツールを気軽に申告できる窓口を設けたりすることで、現場のニーズを直接吸い上げます。

重要なのは、可視化の目的は「犯人探し」ではなく「実態把握」であると明確にメッセージを出すことです。心理的安全性を確保し、協力的な文化を醸成することが、正確な可視化の鍵となります。

原則2:分析 (Analysis) – リスクとビジネス価値を天秤にかける

可視化によって集まった情報を基に、利用されているシャドーAIのリスクとビジネス価値を評価・分類します。すべてのAI利用を同じ尺度で評価するのではなく、メリハリをつけることが重要です。

- ユースケースの棚卸し: 「議事録の要約」「翻訳」「プログラミングの補助」「マーケティングコピーの作成」など、AIがどのような業務(ユースケース)で利用されているかを整理します。

- リスクと価値のスコアリング: 各ユースケースについて、「取り扱うデータの機密性」「影響範囲の広さ」といったリスク軸と、「業務効率の向上度」「創造性の支援度」といった価値軸でスコアリングし、マトリクス上にプロットします。

| リスク(低) | リスク(中) | リスク(高) | |

|---|---|---|---|

| 価値(高) | 【公式化を推進】 ・アイデアのブレスト ・公開情報の要約 | 【ガードレール付きで許容】 ・社内文書の翻訳 ・ソースコードのリファクタリング | 【厳格管理・代替策検討】 ・顧客データの分析 ・人事評価の草案作成 |

| 価値(低) | 【ガイドライン内で自由利用】 ・一般的な文章校正 | 【利用を推奨しない】 | 【原則禁止】 ・個人情報を含む問い合わせ対応 |

この分析により、「どの領域から公式化を進めるべきか」「どの領域は厳しく制限すべきか」という優先順位が明確になります。

原則3:公式化 (Officialization) – 安全な「公式ルート」を用意する

分析結果に基づき、ビジネス価値が高く、リスクが管理可能だと判断されたユースケースについては、安全に利用できる「公式AIツール」を提供します。これがシャドーAI対策の最終ゴールです。

- 安全な代替手段の提供: 従業員がシャドーAIを使っていたのは、公式な代替手段がなかったからです。セキュリティが担保された公式ツールを提供することで、従業員はリスクを冒してまで未承認ツールを使う必要がなくなり、シャドーAIは自然に減少していきます。

- ガードレールの実装: 公式ツールには、シングルサインオン(SSO)による認証、アクセスログの取得、入力データのマスキング(匿名化)、利用権限の制御といった、必要なセキュリティ機能(ガードレール)を実装します。

- 利用ガイドラインと教育: 公式ツールをどのように使えば安全かつ効果的かを示す明確なガイドラインを作成し、全従業員に周知・教育します。

この「可視化→分析→公式化」のサイクルを継続的に回していくことで、組織はAIのリスクをコントロールしながら、その恩恵を最大限に引き出すことができるようになります。

第4章:【ステップ1:予防】リスクを未然に防ぐための基盤づくり

インシデントが発生してから対応するのでは手遅れです。効果的なシャドーAI対策は、リスクの発生を未然に防ぐ「予防」から始まります。ここでは、その基盤となる「ポリシー策定」「教育・啓発」「技術的制御」の3つの柱について解説します。

1. ポリシー策定:判断の拠り所となるルールを定める

まず、AI利用に関する全社的な方針とルールを明文化した「AI利用ポリシー」を策定します。これは、従業員が「何をすべきで、何をしてはいけないのか」を判断するための拠り所となります。ポリシーは抽象的な精神論ではなく、具体的で実行可能なものでなければなりません。

【AI利用ポリシー策定チェックリスト10項目】

- [ ] 定義と適用範囲:

- 「生成AI」とは何を指すか(社内外のツール、API連携を含むか)。

- ポリシーが適用される対象者(全従業員、業務委託先など)と対象機器(会社支給、私物端末)を明確にする。

- [ ] 許容事項と禁止事項:

- 入力が固く禁止されるデータを具体的に列挙する(例:個人情報、顧客の機密情報、未公開の知的財産、取引先の非公開情報)。

- 業務で利用が許容されるユースケースと、事前承認が必要なユースケースを例示する。

- [ ] 承認プロセス:

- 新しいAIツールの利用や、新たなユースケースでの活用を希望する場合の申請フローを定める(申請→リスク評価→トライアル→本番導入)。

- [ ] データの取り扱い:

- AIに入力したデータの保存期間、破棄のルール。

- AI提供者によるデータ再学習の可否に関する方針。

- 機密データを扱う際のマスキング(匿名化・仮名化)要件。

- [ ] ログ取得と監査:

- 利用ログの保存期間と管理責任者。

- 定期的な利用状況の監査に関する方針。

- [ ] 教育とトレーニング:

- 全従業員が受講必須のAIリテラシー研修について定める。

- 特定のツールを利用するための資格やトレーニング要件。

- [ ] 例外管理:

- 緊急時など、やむを得ずポリシーの例外的な対応が必要な場合の申請と承認プロセス。

- [ ] ベンダー管理:

- 外部AIサービスを選定する際のセキュリティ評価基準(第三者認証の有無など)。

- 契約時に含めるべきデータ保護条項。

- [ ] 罰則規定:

- ポリシーに違反した場合の懲戒手続きについて就業規則と連携して定める。

- [ ] ポリシーの見直し:

- 技術の進展や利用状況の変化に応じて、ポリシーを定期的に(例:半期に一度)見直すプロセスを定める。

2. 教育・啓発:従業員を最初の防衛線にする

どれほど優れたポリシーも、従業員に理解され、遵守されなければ意味がありません。従業員一人ひとりのセキュリティ意識を高め、AIを賢く安全に使いこなすためのリテラシーを育む教育プログラムが不可欠です。

- 「なぜダメなのか」を伝える: 単に禁止事項を羅列するのではなく、「なぜこの情報を入力してはいけないのか」を、具体的なインシデント事例を交えて説明し、リスクを自分事として捉えてもらうことが重要です。

- 実践的なトレーニング:

- 15分でわかる「入力禁止データ」クイズ: 実際の業務シーンを想定したクイズ形式で、入力して良い情報とダメな情報の境界線を体感的に学んでもらう。

- 安全なプロンプト術: 要約、翻訳、ブレストといった比較的リスクの低いユースケースで、機密情報を含まずにAIの能力を引き出すプロンプトの書き方(テンプレート)を提供する。

- ファクトチェックの習慣化: AIの出力には誤り(ハルシネーション)が含まれることを強調し、必ず出典を確認したり、複数の情報源で裏付けを取ったりする検証プロセスを指導する。

- 継続的な情報発信:

- 一度の研修で終わらせず、社内報やチャットツールで、匿名の社内ヒヤリハット事例や安全な活用テクニックを毎月配信するなど、継続的に意識を喚起する。

- 心理的安全性の確保: 「もし間違って機密情報を入力してしまったら、隠さずにすぐに報告してください。報告したことで罰せられることはありません」というメッセージを明確に伝え、早期相談を促す文化を醸成する。

3. 技術的制御(ガードレール):仕組みでリスクを低減する

人間の注意深さだけに頼るには限界があります。ポリシーを補完し、意図しない違反を防ぐための技術的なガードレールを導入します。

- ネットワークレベルでの制御:

- ファイアウォールやセキュアWebゲートウェイを用いて、リスクが高いと判断された未承認AIサービスへのアクセスをURLフィルタリングでブロックする。

- ただし、いきなりブロックするのではなく、「警告画面を表示し、利用申請ページへ誘導する」といった段階的なアプローチが現場の混乱を招きにくい。

- IDベースのアクセス制御:

- 公式に導入するAIツールは、必ず会社のID基盤(Azure AD, Oktaなど)と連携させ、シングルサインオン(SSO)を必須とする。

- これにより、「誰が」「いつ」利用したかを確実に追跡でき、退職者のアカウントを即座に無効化できる。

- データ保護の仕組み:

- DLP (Data Loss Prevention) ツールを導入し、機密情報や個人情報を含むデータが、監視対象のAIサービスにアップロードされそうになった際に、検知・ブロックする。

- 機密データを扱う前に、自動でマスキング処理を行う社内ゲートウェイや専用ポータルを用意する。

- エンドポイントの管理:

- MDM (Mobile Device Management) やEDRツールを用いて、会社の管理下にない危険なブラウザ拡張機能やアプリケーションのインストールを禁止・制限する。

これらの予防策を組み合わせることで、シャドーAIのリスクが発生する確率を大幅に引き下げることができます。

第5章:【ステップ2:検知】隠れた利用を可視化する技術と運用

完璧な予防策は存在しません。ポリシーや教育をすり抜けて利用されるシャドーAIを早期に発見し、対処するための「検知」の仕組みが不可欠です。検知の目的は、利用を罰することではなく、リスクのある利用を把握し、安全な公式ルートへ誘導することにあります。

ログの三層構造で利用実態を捉える

シャドーAIの利用を多角的に捉えるため、異なるレイヤーのログを組み合わせて分析することが効果的です。

- ネットワーク層ログ(誰がどこにアクセスしたか):

- 対象ログ: プロキシ、ファイアウォール、DNSクエリログ

- わかること: 社内ネットワークから、どのAIサービス(ドメイン/URL)に対して、どの端末(IPアドレス)から、どれくらいの頻度・データ量でアクセスがあったかを把握できます。既知のAIサービスリストと照合することで、未承認ツールの利用を大まかにスクリーニングします。

- エンドポイント層ログ(端末で何が行われたか):

- 対象ログ: EDR、資産管理ツールのログ

- わかること: 従業員のPC上で、どのようなアプリケーションが実行されたか、どのブラウザ拡張機能がインストールされているかを把握できます。また、クリップボードの操作ログやファイルI/Oログを監視することで、「機密ラベルが付いたファイルの内容がコピーされ、特定のWebサイトにペーストされた」といった、より詳細なリスク行動を検知することも可能です。

- SaaS層ログ(クラウド上で何が起きているか):

- 対象ログ: CASB、SSPM (SaaS Security Posture Management) のログ

- わかること: 従業員が会社のメールアドレスを使って個人で登録したSaaS(シャドーIT/AI)を自動で検知します。どのサービスに、誰が登録しているかを可視化し、リスク評価を行うことができます。

検知運用のための実務指標(KPI)

検知活動の成果を測定し、改善に繋げるために、以下のようなKPIを設定します。

- 未承認AIアクセス率: (未承認AIサービスへのアクセスセッション数) / (全てのAIサービスへのアクセスセッション数)

- この比率が低下すれば、公式ツールへの移行が進んでいることを示します。

- 高リスクデータ入力検知件数: DLPなどで検知された、機密情報や個人情報のAIサービスへのアップロード試行件数。

- ポリシー違反行動の発生頻度を測る指標です。

- 利用申告件数と承認率: 従業員からのAIツール利用申請の数と、そのうち承認された割合。

- 申告しやすい文化が醸成されているか、また、承認プロセスが適切に機能しているかを測る指標です。

アラート運用のポイント:罰ではなく、行動変容を促す

検知システムからアラートが上がった際の対応は、慎重に行う必要があります。

- 初期段階では「啓発」を目的とする: いきなりアクセスを遮断したり、本人に警告したりするのではなく、「このようなツールの利用は会社のポリシーで制限されています。業務で必要な場合は、こちらのフォームから申請してください」といったメッセージを表示し、公式な手続きへ誘導することを優先します。

- 閾値は段階的に厳格化: 最初は誤検知(False Positive)も多いため、ルールは緩めに設定します。運用を続けながらチューニングを行い、本当にリスクの高い行為に絞ってアラートレベルを上げていきます。

- ポジティブなフィードバックも共有する: 月次のセキュリティレポートなどで、検知されたリスク事例だけでなく、「公式ツールを活用した業務改善の成功事例」も合わせて共有することで、ポジティブな行動変容を促します。検知=罰というネガティブなイメージを払拭することが、協力的な文化を築く上で極めて重要です。

第6章:【ステップ3:対応】インシデント発生時の具体的なアクションプラン

どれだけ予防と検知を徹底しても、インシデント(事故)が発生する可能性をゼロにすることはできません。重要なのは、インシデントが発生した際に、被害を最小限に食い止め、迅速かつ的確に対応できる準備を整えておくことです。

1. 初動判断(トリアージ):インシデントの緊急度を見極める

インシデントの報告を受けたら、まずその重大度を迅速に評価し、対応の優先順位を決定(トリアージ)します。

- 重大度S1(緊急):

- 状況: 個人情報や取引先の機密情報が外部のAIサービスに送信された可能性が高い。顧客や業務への実害が発生する恐れがある。

- 対応: 即座にインシデント対応チームを招集し、封じ込めを開始する。

- 重大度S2(高):

- 状況: 社内の機密情報が送信されたが、影響範囲は限定的。早期の封じ込めが可能。

- 対応: 担当部署内で対応を進め、必要に応じて上位組織にエスカレーションする。

- 重大度S3(中):

- 状況: ポリシー違反のAI利用があったが、機密情報の送信は確認されず、実害の可能性は低い。

- 対応: 当該従業員への注意喚起と再教育を主とし、是正を確認する。

2. 封じ込め:被害の拡大を阻止する

インシデントの影響がそれ以上広がらないように、迅速に封じ込め措置を実施します。

- ネットワーク隔離: 影響が疑われる端末をネットワークから隔離し、さらなる情報漏洩やマルウェアの拡散を防ぎます。

- アカウント停止: 関連する従業員のアカウントや、利用されたAIサービスのアカウントを一時的に停止します。

- サービス事業者への削除依頼: 利用されたAIサービスの利用規約に基づき、入力されたデータの削除やアカウントの停止を依頼します。(ただし、事業者が対応してくれるとは限りません)

- 外部への流出確認: 検索エンジンのキャッシュや、情報が公開されうる場所にデータが流出していないかを確認します。

3. 調査:何が起きたのかを正確に把握する

封じ込めと並行して、インシデントの全体像を解明するための調査を行います。

- 5W1Hの特定: 「いつ(When)」「誰が(Who)」「何を(What)」「どこに(Where)」「なぜ(Why)」「どのように(How)」情報が入力・共有されたのかを、各種ログやヒアリングを通じて時系列で再構築します。

- 影響範囲の特定: 漏洩した可能性のある情報の機密レベル(極秘、秘、社外秘など)、件数、内容を特定します。個人情報保護法などの法令や、顧客との契約に違反していないかを確認します。

- 根本原因の分析: なぜこのインシデントが起きたのか、根本的な原因を追究します(例:教育不足、承認プロセスの煩雑さ、技術的制御の欠如など)。

4. 通知と是正:関係者への適切なコミュニケーション

調査結果に基づき、社内外の関係者への通知と、具体的な是正措置を実施します。

- 社内報告: 経営層、法務部門、広報部門、関連事業部門の責任者など、関係者に事実を正確に報告し、対応方針を協議します。

- 外部通知: 法令や契約に基づき、監督官庁(個人情報保護委員会など)や影響を受ける顧客・取引先への通知が必要かどうかを判断し、実行します。透明性を確保し、誠実に対応することが、信頼回復の鍵となります。

- 再発防止策の策定と実行: 根本原因分析の結果を踏まえ、具体的な再発防止策を「短期(即日)」「中期(1週間)」「長期(1ヶ月)」の時間軸で策定し、実行に移します。

5. 学習と改善:インシデントを組織の糧に変える

インシデント対応は、後始末で終わらせてはいけません。今回の失敗から学び、組織全体のセキュリティレベルを向上させる絶好の機会です。

- インシデント報告書の作成: 発生経緯、原因、対応、再発防止策をまとめた報告書を作成し、学びを組織の知識として蓄積します。(個人が特定されないよう匿名化することが重要)

- 各種プロセスの見直し: 今回のインシデントを踏まえ、AI利用ポリシー、教育コンテンツ、検知ルール、技術的制御などをアップデートします。

- 効果測定: 実施した再発防止策が、実際に同様のインシデントの発生率を低下させているかを、次期四半期のKPIとして測定・評価します。

第7章:【部門別】現場で使えるシャドーAIガードレール具体例

全社一律のルールだけでなく、各部門の業務内容に合わせた、より具体的で実践的なガードレールを示すことが、ポリシーを現場に浸透させる上で非常に効果的です。ここでは、特にAI利用が進みやすい3つの部門を例に、具体的な安全策を紹介します。

1. ソフトウェア開発部門

開発者は生産性向上のため、コード生成、デバッグ、ドキュメント作成などにAIを積極的に活用する傾向があります。

- ありがちなリスク:

- 開発中のソースコードや、脆弱性情報を含むコード断片を、外部のAIサービスに貼り付けてしまう。

- 未公開のAPIキーや認証情報がコードに含まれたまま、AIに入力してしまう。

- 安全なガードレール:

- 原則: 会社の知的財産であるソースコードの外部サービスへの投稿は原則禁止とする。

- 代替策:

- セキュリティが確保された社内環境でホストできるAIコーディング支援ツール(例: GitHub Copilot for Business)や、社内データでファインチューニングした独自モデルを導入する。

- 設計情報やアルゴリズムの相談をしたい場合は、具体的なコードではなく、擬似コードやロジックを説明する文章に変換してから入力する。

- 品質管理:

- AIが生成したコードは、必ず人間のエンジニアによるコードレビューと、SAST(静的アプリケーションセキュリティテスト)ツールによる脆弱性スキャンを必須とする。AIはあくまで「アシスタント」であり、最終的な品質責任は人間が負うことを徹底する。

2. 営業・マーケティング部門

提案書作成、顧客へのメール文面、マーケティングコピーの生成など、文章作成業務が多いこれらの部門では、AIの活用ニーズが非常に高いです。

- ありがちなリスク:

- 提案書作成の効率化のため、顧客名、取引金額、契約条件といった機密情報をAIに入力してしまう。

- AIが生成した市場分析レポートや製品紹介文のファクトチェックを怠り、誤った情報を顧客に提示してしまう。

- 安全なガードレール:

- 原則: 顧客情報や個別の取引条件など、社外秘にあたる情報はマスキング(匿名化)してから入力する。

- 代替策:

- 「顧客A」「製品X」のように情報を仮名化する、あるいは、数値データを「約XX%増」のように丸める、といったマスキングルールを具体的に示す。

- 社内の承認済みテンプレートや製品情報を学習させた、クローズドな環境のAIチャットボットを営業支援ツールとして提供する。

- 品質管理:

- AIが生成した文章、特に統計データや専門的な記述を含む場合は、必ず出典や元データを確認する二重のファクトチェックプロセスを義務付ける。

- 最終的に顧客に提示する文書は、必ず上長や関連部署の承認を得るフローを維持する。

3. カスタマーサポート・FAQ部門

顧客からの問い合わせ対応の効率化や、FAQコンテンツの作成にAIを活用するケースが増えています。

- ありがちなリスク:

- 顧客からの問い合わせ内容(個人情報やトラブルの詳細を含む)を、そのまま外部AIに要約させてしまう。

- AIチャットボットが誤った製品情報やサポート手順を回答し、顧客トラブルを拡大させてしまう。

- 安全なガードレール:

- 原則: 顧客向けの自動応答システムに生成AIを組み込む場合は、必ず「人間の最終承認」ステップを挟むか、回答内容を厳しく制限されたナレッジベースからのみ生成するように設計する。

- 代替策:

- 問い合わせ内容をAIで分析・要約する際は、個人情報を自動的に検知・マスキングする機能を導入する。

- オペレーター向けの回答案サジェスト機能としてAIを活用し、最終的な回答は人間が責任を持って編集・送信する。

- 品質管理と透明性:

- AIによる回答の根拠となった社内ナレッジを記録し、後から監査できるようにしておく。

- 顧客に対して、回答がAIによって生成されていることを明示し、誤りがあった場合のフィードバック窓口を設ける。

第8章:安全な公式AIツール選定で失敗しないための7つの基準

シャドーAIを公式ツールへ誘導するためには、その公式ツールが従業員にとって魅力的で、かつ管理者にとって安全なものでなければなりません。ここでは、公式AIツールを選定・導入する際に確認すべき7つの重要な基準を解説します。

- データ保護とプライバシー:

- 学習利用のオプトアウト: 入力したデータが、AIモデルの再学習に利用されない設定(オプトアウト)が可能か。これは必須条件です。

- データ保存ポリシー: データの保存場所(どの国のデータセンターか)、保存期間、管理者によるデータ削除が可能か。

- 暗号化: 通信経路(TLS)および保存データ(at-rest)が強力な方式で暗号化されているか。自社の暗号化キーを持ち込める(BYOK)オプションはあるか。

- 管理・監査機能:

- ID連携とSSO: Azure ADやOktaなど、自社のIDプロバイダーと連携し、シングルサインオンが可能か。

- 監査ログ: 「誰が」「いつ」「何を入力し」「何を得たか」を記録した監査ログを、長期間(例:1年以上)保存・エクスポートできるか。

- 利用状況ダッシュボード: 部署別、ユーザー別の利用状況やコストを可視化できる管理ダッシュボードがあるか。

- アクセス制御と権限管理:

- ロールベースのアクセス制御: 管理者、一般利用者など、役割に応じた権限を細かく設定できるか。

- 入力フィルタリング: 特定のキーワード(例:「個人番号」「社外秘」)や正規表現パターンを含むプロンプトをブロックする機能があるか。

- 信頼性とサポート:

- SLA(サービス品質保証): サービスの稼働率に関するSLAが定義されており、目標未達の場合の補償があるか。

- 障害対応: 障害発生時の通知方法、復旧目標時間(RTO/RPO)、サポート窓口の対応時間や言語は明確か。

- 機能性と拡張性:

- 社内データ連携(RAG): 社内のドキュメントやデータベースを安全に参照し、それに基づいて回答を生成する機能(Retrieval-Augmented Generation, RAG)があるか。

- モデル選択の柔軟性: 特定のAIモデルにロックインされず、将来的に新しい、より高性能なモデルに切り替えられるか。

- API連携: 他の業務システムと連携するためのAPIが提供されているか。

- 契約とコンプライアンス:

- データ処理条項: データの取り扱いに関する責任分界点、準拠法、管轄裁判所などが契約書で明確に定められているか。

- 第三者認証: SOC 2, ISO/IEC 27001 といった、独立した第三者機関によるセキュリティ認証を取得しているか。

- コストとROI:

- 料金体系: ユーザー単位、トークン(利用量)単位など、料金体系が明確で、自社の利用予測に合っているか。予期せぬコスト増を防ぐための利用上限設定は可能か。

- 費用対効果: 導入にかかるコストに対し、どれだけの生産性向上やリスク低減が見込めるか(ROI)を試算する。

これらの基準に基づき、複数のベンダーを比較検討し、自社の要件に最も合致したツールを選定することが、公式化を成功させるための重要なステップです。

第9章:シャドーAI対策で陥りがちな5つの落とし穴と回避策

理論上は完璧に見える対策も、実践の場では思わぬ落とし穴にはまることがあります。ここでは、多くの企業が経験する典型的な失敗パターンとその回避策を紹介します。

落とし穴1:完璧なポリシーができるまで「一律禁止」を続ける

完璧を目指すあまりポリシー策定に時間をかけすぎ、その間ずっとAI利用を禁止してしまう。結果、現場の不満が募り、抜け道を探す動きが加速してしまいます。

- 回避策: 完璧主義を捨てる。「暫定ポリシー(バージョン1.0)」として、まずは入力禁止データなどの最重要項目に絞った最低限のルールを迅速に公開する。並行して安全なツールのPoC(概念実証)を開始し、「禁止」だけでなく「安全な代替案」をセットで提示する。

落とし穴2:ポリシーが現場に届かない(抽象的すぎる・周知不足)

法務・IT部門が作った専門用語だらけの長文ポリシーを、イントラネットに掲載しただけで「周知した」と思い込んでしまう。現場の従業員は読まないか、読んでも自分事として理解できません。

- 回避策: ポリシーを「翻訳」する。部門別のユースケースに沿った「具体例(OK例/NG例)」や、ワークフローを図式化した分かりやすいガイドを作成する。全社研修だけでなく、部門ごとの説明会やQ&Aセッションを設けて、対話を通じて理解を深める。

落とし穴3:研修が一度きりで形骸化する

導入時に一度だけ研修を実施し、その後はフォローがない。新しい脅威やツールの登場、従業員の異動などに対応できず、知識が陳腐化・風化してしまいます。

- 回避策: 学習を継続的なプロセスにする。新しい従業員向けのオンボーディング研修に組み込むのはもちろん、四半期ごとのeラーニングや、月次の短いセキュリティニュース配信など、マイクロラーニングの手法を取り入れて、継続的に知識をアップデートする機会を提供する。

落とし穴4:検知と罰を直結させ、従業員を萎縮させる

検知システムでポリシー違反を見つけるたびに、本人や上長に厳しい警告を行う。結果、従業員はミスを恐れてAIの活用自体を躊躇したり、インシデントを隠蔽したりするようになります。

- 回避策: 「性悪説」ではなく「性善説」に立つ。検知の初期目的は、罰ではなく「気づき」と「教育」に置く。違反者には、なぜその行為がリスクなのかを丁寧に説明し、正しい使い方を案内する。例外申請のプロセスを簡素化し、「困ったらまず相談する」文化を醸成する。

落とし穴5:公式ツールの導入プロセスが遅すぎる

現場からの利用申請に対し、セキュリティ評価や承認プロセスに数ヶ月もかかってしまう。待たされた従業員は、結局シャドーAIに逆戻りしてしまいます。

- 回避策: 承認プロセスのファストトラックを設ける。リスクの低いツールやユースケースについては、評価項目を簡略化し、迅速にトライアルを開始できるようにする。最初から100点のツールを目指すのではなく、現場の要求の80%を満たす暫定的な公式ツールを素早く提供し、フィードバックを得ながら改善していくアジャイルなアプローチを取る。

第10章:シャドーAI対策に関するよくある質問(FAQ)

Q1:シャドーAI対策、まず最初の30日間で何をすべきですか?

A1: 以下の4つを並行して進めることをお勧めします。

- 実態把握(1週目〜): 匿名アンケートと、主要なAIサービスへのアクセスログの簡易分析を開始します。

- 暫定ポリシー公開(2週目〜): 「入力禁止データの定義」と「AI利用の相談・申請窓口」を明記した、A4一枚程度の暫定ポリシーを公開します。

- 基礎研修(3週目〜): 15分程度の短いeラーニングで、シャドーAIの基本リスクと暫定ポリシーについて全社に周知します。

- 公式ツール検討開始(2週目〜): IT部門内で、安全な公式ツールの候補をいくつかリストアップし、PoC(概念実証)の計画を立て始めます。

Q2:ログが十分に取れていません。未承認利用を見つける方法はありますか?

A2: 技術的なログが不十分な場合でも、組織的なアプローチで補完できます。

- 匿名アンケートとヒアリング: 最も効果的な方法です。「罰しない」という前提を明確に伝えれば、正直な利用実態が見えてきます。

- ブラウザ履歴の自己申告: 従業員に協力を求め、自主的に利用ツールを申告してもらう制度も有効です。

- パイロット監視: 全社展開の前に、IT部門やDX推進部門など、協力的な部署を対象にパイロット的に監視ツールを導入し、効果を測定します。

Q3:無料版の生成AIを業務で使うのは、やはりダメなのでしょうか?

A3: 入力データがサービス改善(再学習)に使われる可能性があり、データ保護の観点から、機密情報や個人情報を扱う業務での利用は原則として不可とすべきです。公開情報のリサーチやアイデア出しなど、機密情報を含まない用途に限定し、かつ会社のポリシーで許容されている場合に限り、利用が考えられます。ただし、その場合でもセキュリティ脆弱性のリスクは残ります。

Q4:データ汚染による誤予測は、どうすれば防げますか?

A4: 100%の防御は困難ですが、リスクを低減するために複数の対策を組み合わせます。

- データソースの限定: AIが参照・学習するデータは、信頼できる内部データソースや、検証済みの外部データに限定します。

- 変更管理の徹底: 学習データを更新する際は、誰が、いつ、何を、なぜ変更したのかを記録し、承認プロセスを設けます。

- 異常検知: 入力データやモデルの出力に異常な傾向が見られないかを継続的に監視します。

- 人間の介在: 最終的な重要判断はAIに丸投げせず、必ず人間が結果を検証・承認するプロセスを維持します。

Q5:教育の効果はどのように測定すればよいですか?

A5: 受講率やテストの点数といった形式的な指標だけでなく、行動変容に繋がっているかを測るKPIが重要です。

- 未承認AIアクセス率の低下: 教育後に、リスクの高いシャドーAIへのアクセスが減少しているか。

- 高リスク入力検知件数の減少: DLPなどで検知されるポリシー違反が減っているか。

- 安全な利用に関する相談・申請件数の増加: 従業員が隠さずに相談する文化が醸成されているか。

Q6:経営層には、この問題をどのように報告すればよいですか?

A6: 専門用語を避け、ビジネスインパクトに焦点を当てて説明します。

- リスク: 「現状放置すると、年間X件の確率でY円規模の損害(情報漏洩、訴訟など)が発生する可能性があります」と、具体的なシナリオと影響額で示します。

- 価値: 「対策を講じ、安全なAI活用を推進することで、全社でZ%の生産性向上が見込めます」と、ポジティブな側面も強調します。

- 提案: 対策にかかるコスト、ロードマップ、KPIを一枚のスライドにまとめ、具体的な投資判断を仰ぎます。

まとめ:シャドーAIを統制されたイノベーションに変えるために

シャドーAIは、単に禁止したり、監視したりするだけでは解決できない、複雑で根深い問題です。それは、従業員の生産性向上への強い欲求と、組織のガバナンス体制との間に生じたギャップの表れだからです。

この問題への最も効果的で持続可能なアプローチは、シャドーAIを“敵”と見なすのではなく、現場のニーズを映し出す“鏡”と捉え、そのエネルギーを安全で建設的な方向へと導くことです。

本記事で解説した「可視化 → 分析 → 公式化」のサイクルは、そのための具体的なロードマップです。

- まずは可視化によって、水面下で何が起きているのかを正確に把握します。

- 次に分析によって、リスクと価値を冷静に評価し、取り組むべき優先順位を定めます。

- そして公式化によって、従業員が安心して使える安全な「公式ルート」を提供し、シャドーAIを自然に縮小させていきます。

このプロセスには、ポリシーという「ルール」、教育という「文化」、そして技術的制御という「仕組み」の三位一体の取り組みが不可欠です。

シャドーAI対策は、一度行えば終わりというものではありません。AI技術が進化し、ビジネス環境が変化し続ける限り、継続的な見直しと改善が求められる長い旅です。しかし、この旅を正しく進めることができれば、シャドーAIというリスクは、組織全体の生産性と競争力を飛躍させる、統制されたイノベーションへと姿を変えるはずです。

さあ、今日からあなたの組織でできる最初の一歩を踏み出しましょう。この記事が、そのための羅針盤となれば幸いです。

「シャドーAI禁止」で現場が凍り付いたあの日。その、AI導入の裏側 「シャドーAI対策ガイド」なんて記事を書くと、さぞスマートにプロジェクトが進んだように思われるかもしれませんね。チェックリストを作り、ステップに沿って進めれば万事解[…]